Ich sitze vor meinem Bildschirm und schaue zu, wie eine KI versucht, ein Formular auszufüllen. Sie klickt auf das falsche Feld. Wartet. Klickt nochmal. Diesmal trifft sie, aber trägt den Vornamen in das Nachname-Feld ein. Dann scrollt sie irgendwohin, wo niemand hinwollte. Ich will helfen, aber es gibt keinen Weg einzugreifen.

Es fühlt sich an, als würde ich jemandem beim Einparken zusehen, der das Lenkrad nicht versteht. Nur dass das Lenkrad eine Maus ist und der Fahrer das teuerste KI-Modell auf dem Markt.

Willkommen bei Computer Use. Der Funktion, die künstliche Intelligenz endlich in die echte Welt bringen soll. Auf dem Papier klingt das nach Zukunft. In der Praxis? Naja.

Was auf der Demo-Bühne passiert

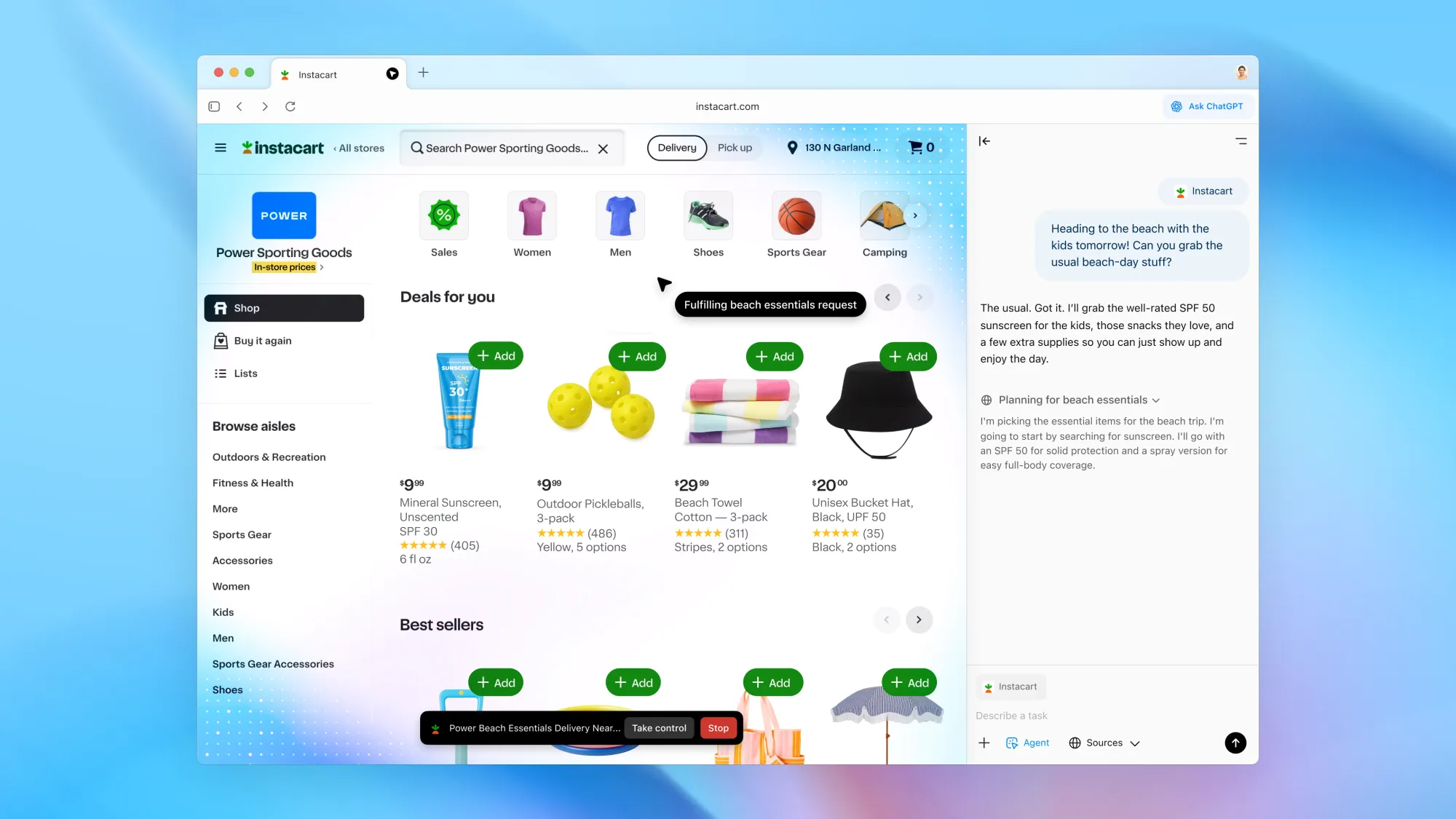

2024 und 2025 kamen die großen Ankündigungen. Anthropic launchte Claude Computer Use – eine API, mit der Claude deinen Desktop steuern kann. OpenAI brachte erst Operator, einen Web-Agenten, der in einem isolierten Cloud-Browser Aufgaben erledigt, angetrieben vom CUA-Modell (Computer-Using Agent). Und dann kam Atlas: ein ganzer Chromium-Browser mit eingebautem ChatGPT und Agent Mode, der nicht nur Aufgaben übernimmt, sondern deinen Browserverlauf, deine Tabs und deinen Kontext kennt. Google zog mit Project Mariner auf Gemini-Basis nach. Die Demos sahen alle beeindruckend aus: KI, die Formulare ausfüllt, Flüge bucht, Lebensmittel bestellt. Die Zukunft der Arbeit von morgen. Aber noch nicht von heute.

Quelle: OpenAI

Nathan Lambert, Post-Training-Lead am Allen Institute for AI, fasst das mit einer Ehrlichkeit zusammen, die ich in der Branche selten höre: Die Demos sind alle schlecht. Nicht „verbesserungswürdig". Nicht „frühe Beta". Schlecht. Derselbe Nathan Lambert, der auch offen zugibt, dass er vier verschiedene KI-Modelle parallel nutzt, weil keins alles kann.

Und als jemand, der seit 2009 Benutzeroberflächen gestaltet mit UX-Design, kann ich erklären, warum. Das Problem ist nicht, dass die KI zu dumm wäre. Das Problem ist, dass Bildschirme für Menschen gebaut sind, nicht für Algorithmen.

Was Computer Use im Kern versucht:

- Pixel auf einem Bildschirm lesen und interpretieren

- Herausfinden, wo man klicken, tippen oder scrollen muss

- Mit Interfaces interagieren, die für menschliche Augen und Hände gemacht wurden

- All das tun, ohne die Infrastruktur darunter zu kennen

Eine künstliche Intelligenz, die direkt mit einem System spricht, eine API, die im Backend läuft das funktioniert. Das funktioniert sogar richtig gut. Aber eine KI, die deinen Bildschirm übernimmt? Die muss dasselbe tun wie du: schauen, verstehen, navigieren. Und genau da wird es absurd, weil UI-Oberflächen nicht für Maschinen designt wurden.

Was niemand sagt

Es gibt einen zweiten Grund, warum Computer Use kaputt ist, und der ist aus meiner UX-Perspektive fast noch spannender: das Spezifikationsproblem.

Sebastian Raschka, KI-Forscher und Autor von „Build a Large Language Model from Scratch", bringt das auf den Punkt: Du musst der KI sagen, was sie tun soll. Klingt simpel. Ist es nicht.

Bei Text kann ich nachsteuern. „Mach es kürzer." „Anderer Ton." „Nochmal." Bei einer KI, die gerade meine Kreditkartendaten in ein Buchungsformular tippt, ist Nachsteuern keine Option. Da muss es beim ersten Mal stimmen.

Wie spezifizierst du „buche mir einen Flug", wenn die KI nicht weiß, dass du einen Fensterplatz bevorzugst, dass du eine Erdnussallergie hast, dass du keine Zwischenstopps über sechs Stunden willst und „günstig" für dich etwas anderes bedeutet als für mich? Das User-Interface zwischen Mensch und KI ist das eigentliche Problem. Nicht die Intelligenz dahinter. Es ist dasselbe Grundproblem, das ich in meinem Artikel über KI und Programmierung beschrieben habe: technisch sauber, aber ohne Gespür für den Kontext.

Das klingt, als wäre Computer Use komplett nutzlos. Ist es nicht. Die Idee ist richtig. Die Ausführung ist nur noch nicht so weit, wie die Demos es versprechen.

Was bei Computer Use wirklich fehlt

- KI versteht Pixel, aber nicht Kontext. Sie sieht einen Button, weiß aber nicht, warum du ihn drücken würdest

- Die Fehlertoleranz ist null. Bei Text ist ein falscher Absatz ärgerlich. Bei einer Flugbuchung ist ein falscher Klick teuer

- Es gibt keinen eleganten Weg, der KI während der Ausführung Feedback zu geben

- Jede Plattform sieht anders aus, Google, Amazon, Slack, Studio Christos und die KI muss jedes Mal neu lernen

Ich sehe das Problem jeden Tag in meiner Arbeit, nur von der anderen Seite. Seit 2009 entwerfe ich Benutzeroberflächen mit UX-Design mit dem Ziel, dass Menschen sie intuitiv verstehen. Farben, Abstände, Hierarchien, alles ist darauf ausgelegt, dass ein Mensch in Millisekunden weiß, wo er hinschauen muss. Für eine KI sind diese Signale Rauschen. Sie hat kein Gefühl für visuellen Rhythmus, keine Erfahrung mit dem „das sieht falsch aus"-Instinkt, der mir bei jedem Interface sofort sagt, ob es funktioniert. Wie KI-Integration in der Praxis wirklich aussieht, ist eben oft ernüchternder als die Keynote vermuten lässt.

Die größte Hürde für künstliche Intelligenz ist nicht Intelligenz. Es ist die echte Welt. Die Welt, in der Interfaces uneinheitlich sind, Formulare keiner Logik folgen und Cookie-Banner alles verdecken. Willkommen in meinem Alltag. Seit siebzehn Jahren.

Vermutlich wird Computer Use irgendwann funktionieren. Aber nicht, weil KI-Modelle schlauer werden. Sondern weil sich die Interfaces ändern müssen, um KI zu verstehen, genauso wie sie sich verändert haben, um Menschen zu verstehen. Das ist keine technische Frage. Das ist eine Design-Frage. Und Design-Fragen? Die brauchen Menschen, die sie stellen. Warum KI uns nicht ersetzen wird, sondern verändert, das zeigt sich nirgends deutlicher als hier.

Studio Christos ✺ KI Kreative Intelligenz